Od momentu, kiedy do obliczeń postanowiono zaprzęgnąć elektronikę, twórców komputerów nękał problem, jak zapisywać częściowe wynik obliczeń. Dane do obliczeń można było wysłać do elektronicznego procesora z kart perforowanych albo z papierowej taśmy dziurkowanej. Wynik końcowy drukowało się na dalekopisie, drukarce wierszowej lub elektrycznej maszynie do pisania. Ale w każdych niebanalnych obliczeniach powstają wyniki pośrednie, które trzeba zapamiętać do dalszych obliczeń. Jeśli chcemy się dowiedzieć, ile to jest 3·(2+8), to trzeba najpierw dodać 2 do 8, zapamiętać wynik i pomnożyć go przez 3. Przykład jest trywialny, ale pokazuje, że pamięć jest w komputerze niezbędnie potrzebna. Jak już ta pamięć jest, to można jej użyć do wielu celów, na przykład także do przechowywania programów, ale jak jej nie ma, to samodzielna praca komputera jest niemożliwa.

Pierwsze pamięci na przekaźnikach

Gdy powstały pierwsze komputery elektromechaniczne, można było zapamiętywać informację na przekaźnikach. Przekaźnik to taki mały elektromagnes. Jak płynie w nim prąd, to przyciąga on żelazną zworę, która łączy styki w innym obwodzie. W ten sposób przepływ prądu w uzwojeniu przekaźnika decyduje o tym, czy w tym drugim obwodzie przepływ prądu jest możliwy czy nie.

Pamięć składała się z wielu takich przekaźników. Jedne miały zworę przyciągniętą, inne wyluzowaną, co odpowiadało cyfrom 1 i 0 – i taką informację można było łatwo zapisać, włączając i wyłączając prąd w ich uzwojeniach (byle nie wyłączyć zasilania, bo wtedy wszystkie przekaźniki puszczą). Wytworzony zapis w takiej pamięci bez trudu odczytywano (sprawdzając, gdzie są zwarte styki, a gdzie nie) i dowolnie długo przechowano.

Ale elektromechaniczny komputer z przekaźnikami działał wolno. Żeby przyspieszyć jego pracę, zaczęto w procesorze używać elektroniki. Tylko jak już komputer był w całości elektroniczny (na przykład ENIAC), to zapamiętywanie informacji na „kłapiących" przekaźnikach nie wchodziło w rachubę.

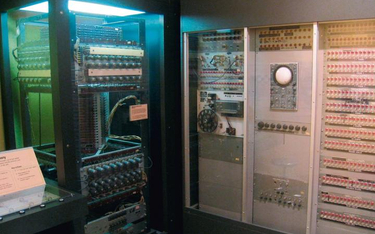

Informacja krążąca w rurach z rtęcią

Jako pierwszy opisaną trudność przezwyciężył w 1949 r. Terence Williams, który wynalazł pamięć opartą na rurach z rtęcią. Skorzystał z tego, że impuls ultradźwiękowy w rtęci rozchodził się stosunkowo wolno (1407 m/s). Mając rurę o długości kilku metrów i wpuszczając do niej na jednym końcu krótkie (1 ms) impulsy ultradźwiękowe, można było spowodować, że w jednej rurze biegły sobie – jeden za drugim – aż 1024 bity informacji. Gdy te impulsy dobiegały do drugiego końca rury, pobudzały umieszczony tam odbiornik ultradźwięków (taki, jak przy badaniu USG) i były przesyłane jako sygnały elektryczne na początek rury i powtórnie wpuszczane do niej jako impulsy ultradźwiękowe.